Live2D self incarnation

Live2D の身体にセルフ受肉したお話です

Created: 2023-03-01 01:00 JST

Last modified: 2023-03-01 01:00 JST

利用しているアプリケーション

- 元となる絵作成 -> iPad Procreate

- 追加のパーツ分割・微調整 -> Windows ソースネクスト Paintgraphic4 pro

- Live2D モデリング -> Live2D Cubism

- 受肉・フェイストラッキング -> VTubeStudio

受肉自体は PC で完結する形でやらせてもらっています

元となる絵の準備

古い人間なのでハイブリット環境で作画しております

紙に描いたラフをスキャンしてから、それを下地にデジタルで線画、塗り

Live2d でモデリングするにはパーツ分けが必要になるので、あらかじめ線画を分けて描いた

追加で一部分割が必要になったが、ほぼほぼ元の絵をいじることなく作業に入れた

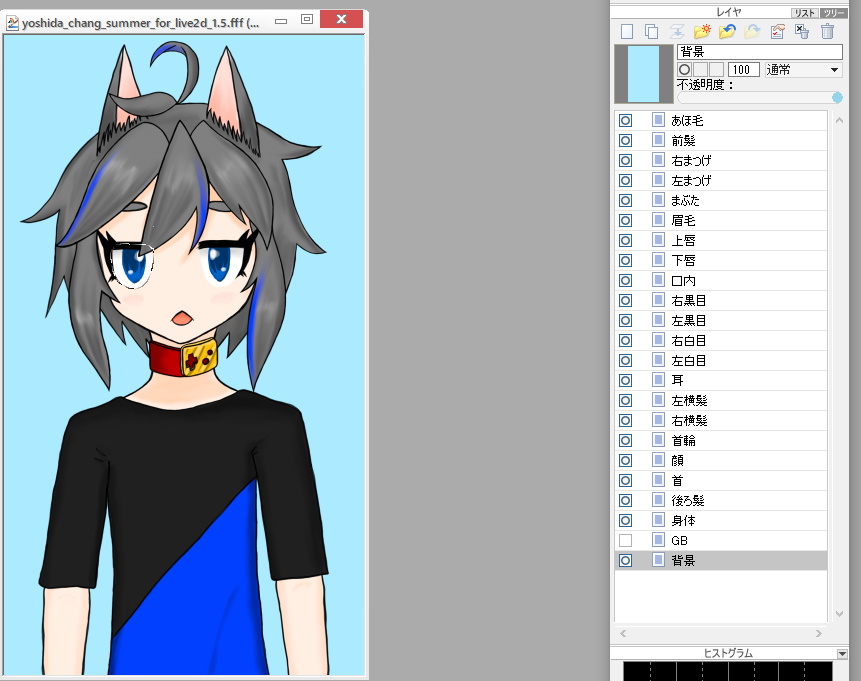

パーツ分割はこんな感じ

Live2D でのモデリング

公式のチュートリアル を参照しながら、ほぼそのまま進めた

公式チュートリアルが非常によくできていて、この通りに進めれば自分の描いた絵が動く!

顔の XY の動き付けは難易度が高めなので、 4 章まで実装できたら書き出ししちゃってみてもいいかも

今回は特別高可動化するようなことはしなかったけど、上下左右の可動だけちょっとオリジナリティを出している

チュートリアルにはないが、デフォーマーの使い方の応用で呼吸も設定している

髪の揺れも表現したかったので 物理の設定ガイド を参考に入れてみた

モデルの書き出しとインポート

モデル書き出しにあたってテクスチャアトラス作成が必要になるので、それをやること

モデルを形式指定してエクスポート 組み込み用じゃなくて OK

物理演算組んだ場合は物理演算用ファイルも別途エクスポートが必要

生成されたファイル群を VTubeStudio のモデルフォルダに全てコピペすると認識してくれる

VTubeStudio でのパラメータマッピング

モデル選択をしてあげればオートでパラメータマッピングしてくれる

呼吸や髪の揺れなどのパラメータは個別に設定してあげる

リップシンクはマイクの音量とリンクさせた (オンマイク環境が多くて口元トラッキングムズカシイので)